신경망학습은 활성화함수를 이용하여

다층으로 학습을 이어가 계속 학습할 수 있도록하며,

가중치의 매개변수의 최적값을 자동으로 획득함.

이때, 가중치의 매개변수를 최적화하여 손실함수의 결과값을 가장 작게 하는 것이 학습의 목표임

Epoch(딥러닝을 수행하면서 학습데이터가 모두 소진되는 하나의 단위)

10,000개를 100개의 batch_size로 학습할 때, 100회가 1epoch

[가중치 초깃값 설정 기법]

| 유형 | 설명 | 활성화 함수 |

| Xaiver(사이베르) 초기값 | 앞 계층의 노드가 n개 일 때, 표준편차가 1/√n인 정규분포를 이용 | 선형함수 |

| He 초깃값 | 앞 계층의 노드가 n개 일 때 표준편차가 √("2/" n) 인 정규분포를 이용 | ReLU |

비용함수(Cost Function), 손실함수

- 신경망 성능의 “나쁨”을 나타내는 지표로, 현재의 신경망이 훈련 데이터를 얼마나 잘 처리하지 못하느냐를 나타내는 지표

* Gradient descent algorithm을 이용하여 cost function 최소화

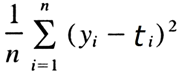

평균제곱오차 Mean Squared Error, MSE

- 각 원소의 출력(추정) 값과 정답 레이블(참) 값의 차 (yk –tk)를 제공한 총합

교차 엔트로피 오차 Cross Entropy Error, CEE

- 정답일 때의 출력이 전체 값을 정하게 되는 자연로그를 이용한 오차 측정 기법

| 구분 | 오차함수 | 오차함수 설명 및 수식 |

| 평균 제곱 오차 |

mean_squared_error | 평균 제곱 오차, mean(square(yt-yo)) |

| mean_absolut_error | 평균 절대 오차, mean(abs(yt-yo)) | |

| mean_absolute_percentage_error | 평균 절대 백분율 오차, mean(abs(yt-yo)/abs(yt)) | |

| mean_squared_logarithmic_error | 평균 제곱 로그 오차, mean(square(log(yo)+1) – (log(yt)+1)) | |

| 교차 엔트로피 |

Categorical_crossentropy | 범주형 교차 엔트로피(일반적인 분류) |

| Binary_crossentropy | 이항 교차 엔트로피(2개의 클래스 중에서 예측할 때) |

728x90

'딥러닝' 카테고리의 다른 글

| 역전파 알고리즘(Backpropagation), 오차역전파법 (0) | 2021.11.30 |

|---|---|

| 경사하강법(Gradient Descent Method) (0) | 2021.11.30 |

| 활성화 함수(Activation Function)-(1/3) (0) | 2021.11.30 |

| 인공지능의 연구 목적은 무엇인가? 아실로마 AI 원칙 (ASILOMA AI Principles) (0) | 2021.11.30 |

| 이미지? 음성? 소설책? 무엇이든지 만들어내는 인공신경망, GAN(Generative Adversarial Networks) (0) | 2021.11.30 |